NVIDIA H200×8枚挿しサーバーが業界最安級で使える

AIスパコンクラウドはNVIDIA H200を搭載したGPUインスタンスが業界最安級で使えるクラウドサービスです。

LLMなどの生成AIや大規模なシュミレーションの計算時間を短縮します。

大規模なワークロードに対応

H200は、H100に比べて1.7倍のGPUメモリを搭載しているため、膨大なパラメーターをもつLLMモデルに対応可能です。

また、LLMで重要視される「GPUメモリ帯域幅」も、H100と比較して1.4倍に向上しています。

これによりデータ転送がさらに高速化し、計算速度が向上しています。

AIスパコンクラウドの3つのサービス

| 高速コンピューティング |

| 月額固定金額で HGX H200ベアメタルサーバーを 1台から利用可能。 |

| 計算クラスタ ※2025年夏 |

| ジョブ単位のポイント制(予定)で HGX H200サーバーを 1枚から枚数を指定して利用可能。 |

| 【専用】プライベートクラウド |

| 大規模なワークロード向けにHGX H200を マルチノードクラスタで提供します。 個社向けにさまざまなカスタマイズが可能です。 |

※ 初期費用はかかりません。月額費用は1ヶ月(30日間)の積算値になります。税込価格になります。

※ 為替は2023年の年間平均になります(1USD = 141JPY)

【事例】バイオインフォマティクス

生体高分子(タンパク質、DNA、RNA)などの、動的な構造解析を行う分子動力学(Molecular Dynamics)シミュレーションでは、数万個に1つの原資について、数千回の計算が必要です。

そのためGPUSOROBANの大容量インスタンスを活用することで、シミュレーションを短時間で完了し、研究開発の効率が大幅に向上しました。

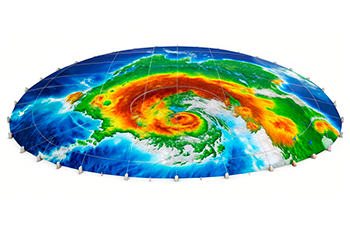

【事例】環境シュミレーション

環境予測では、多くの自然環境データを組み合わせた複雑な計算が必要です。

従来の手法に合わせて機械学習を用いることにより、精度の高い予測が可能になってきましたが、その分析には大量の演算処理が必要となります。

GPUSOROBANのH200インスタンスを活用することで、予測精度の向上と処理時間の短縮を実現しています。

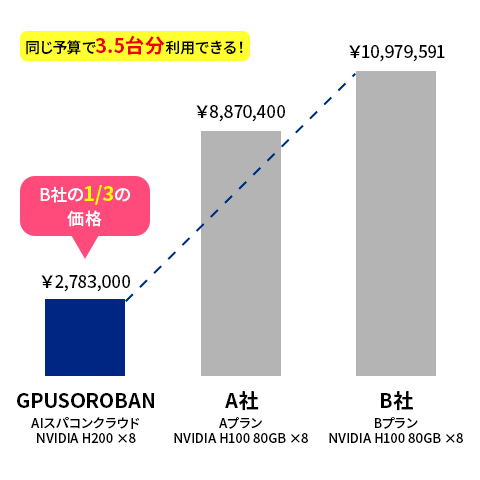

上記機種のNVIDIA H200が1/3の価格で利用できる

| サービス | GPUSOROBAN AIスパコンクラウド |

A社 | B社 |

| プラン | HGX H200スタンドアロン | Aプラン | Bプラン |

| 月額費用(税込み) | ¥2,783,000 | ¥8,870,400 | ¥10,979,591 |

| GPU | NVIDIA H200(SXM) x8枚 | NVIDIA H100(SXM) x8枚 | NVIDIA H100(SXM) x8枚 |

| GPUメモリ | 総計 1,128GB | 総計 640GB | 総計 640GB |

| vCPU | 112コア | 112コア | 192コア |

| システムメモリ | 2TB | 2TB | 2TB |

| ストレージ | 30TB | 60TB | 30TB |

| 演算性能 (FP16 Tensorコア) |

15.8PFLOPS | 15.8PFLOPS | 15.8PFLOPS |

| リージョン | 日本 | 米国 | 米国東部 |

※ 初期費用はかかりません。月額費用は1ヶ月(30日間)の積算値になります。税込価格になります。

※ 為替は2023年の年間平均になります(1USD = 141JPY)

※ AIスパコンクラウドの料金は、予約申込時の特別価格になります。